не работает VK

«Люди, события, факты» — вы делаете те новости, которые происходят вокруг нас. А мы о них говорим. Это рубрика о самых актуальных событиях. Интересные сюжеты и горячие репортажи, нескучные интервью и яркие мнения.

События внутренней, внешней и международной политики, политические интриги и тайны, невидимые рычаги принятия публичных решений, закулисье переговоров, аналитика по произошедшим событиям и прогнозы на ближайшее будущее и перспективные тенденции, публичные лица мировой политики и их «серые кардиналы», заговоры против России и разоблачения отечественной «пятой колонны» – всё это и многое вы найдёте в материалах отдела политики Царьграда.

Идеологический отдел Царьграда – это фабрика русских смыслов. Мы не раскрываем подковёрные интриги, не «изобретаем велосипеды» и не «открываем Америку».

Расследования Царьграда – плод совместной работы группы аналитиков и экспертов. Мы вскрываем механизм работы олигархических корпораций, анатомию подготовки цветных революций, структуру преступных этнических группировок. Мы обнажаем неприглядные факты и показываем опасные тенденции, не даём покоя прокуратуре и следственным органам, губернаторам и «авторитетам». Мы защищаем Россию не просто словом, а свидетельствами и документами.

Экономический отдел телеканала «Царьград» является единственным среди всех крупных СМИ, который отвергает либерально-монетаристские принципы. Мы являемся противниками встраивания России в глобалисткую систему мироустройства, выступаем за экономический суверенитет и независимость нашего государства.

Мы являемся противниками встраивания России в глобалисткую систему мироустройства, выступаем за экономический суверенитет и независимость нашего государства.

Не работает VK Coin — что делать?

Автор Евгений На чтение 4 мин Опубликовано Обновлено

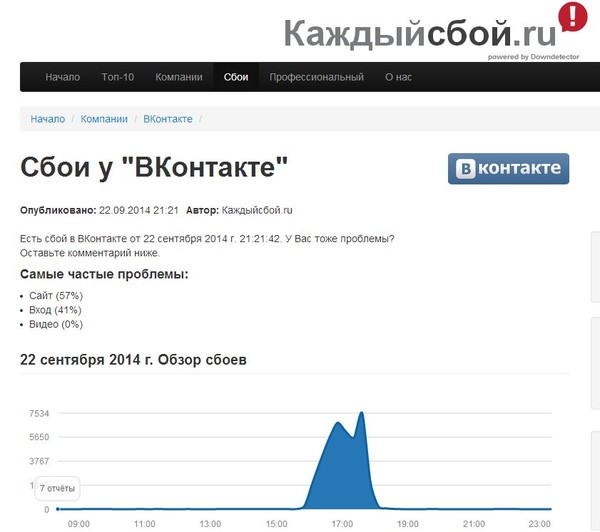

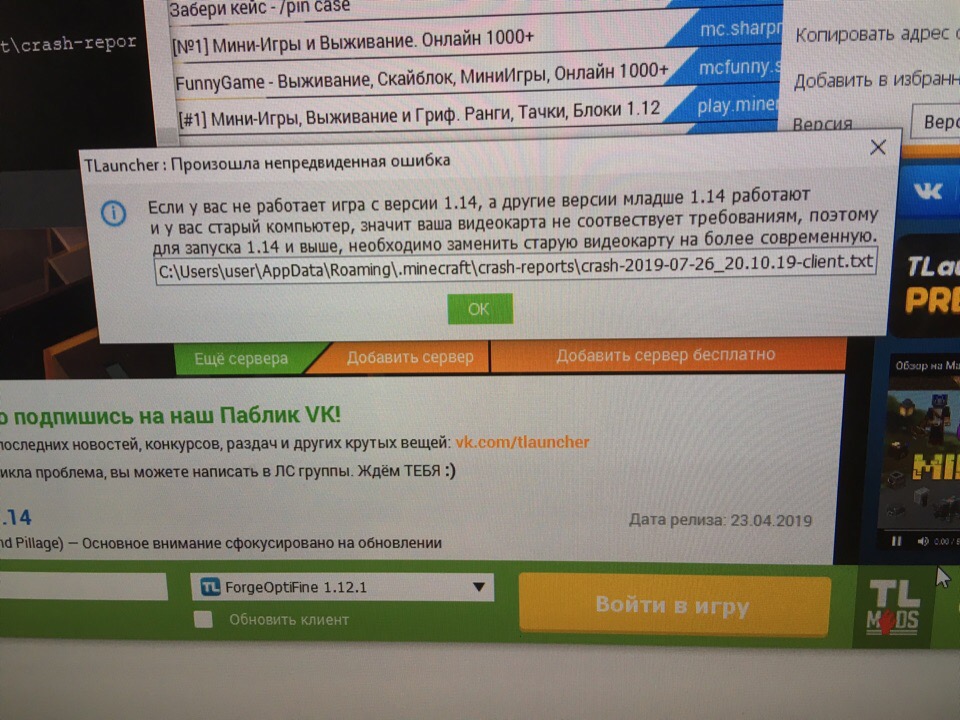

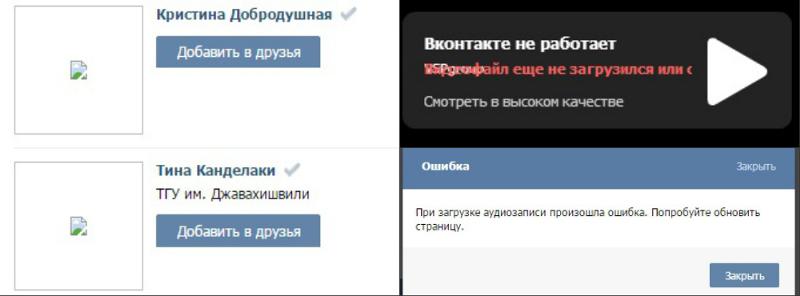

С момента запуска ВК коин прошло 5 дней, но уже набралось рекордное количество посетителей, которые просто сносят сайт. Заманчивое предложение «Стань самым богатым в контакте» коснулось очень многих, все хотят себе, как можно больше коинов. Для чего они нужны и как их зарабатывать мы рассказывали в этой статье ссылка. В связи с большой активностью постоянно лагает и может не заходить на сайт, не работать приложение. Мы расскажем вам, как поступать в такой ситуации. Давайте разберемся, что делать если VK Coin не запускается или вовсе не поддерживаться на вашем устройстве.

В чем проблема?

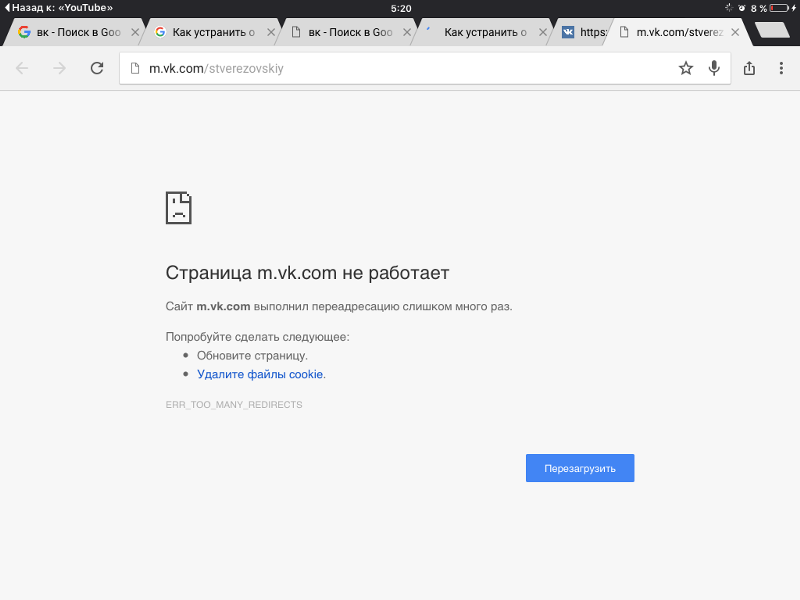

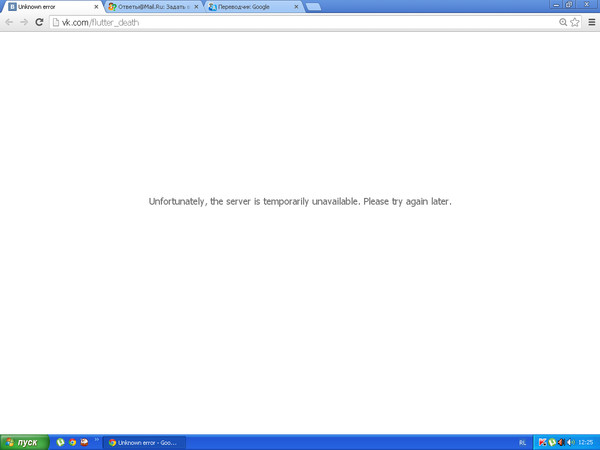

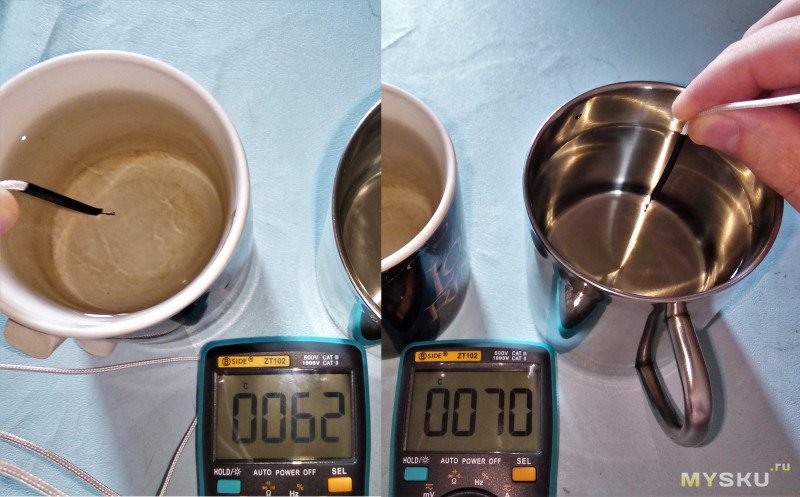

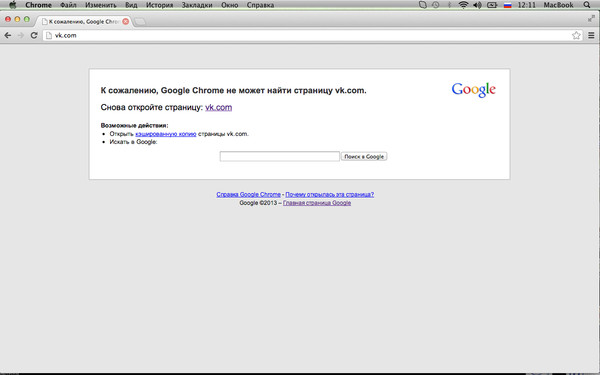

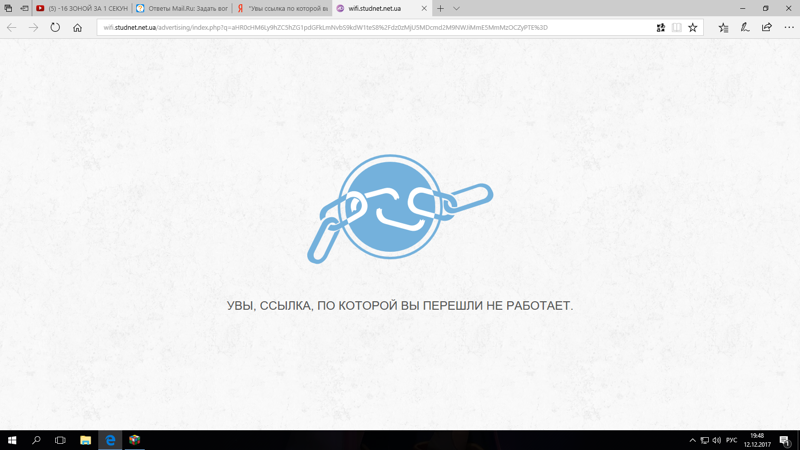

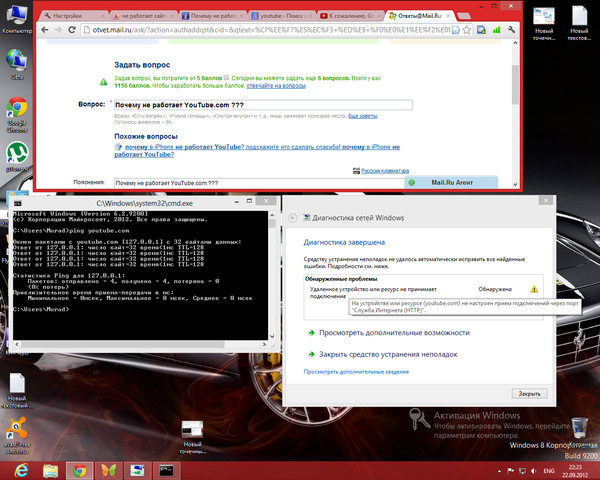

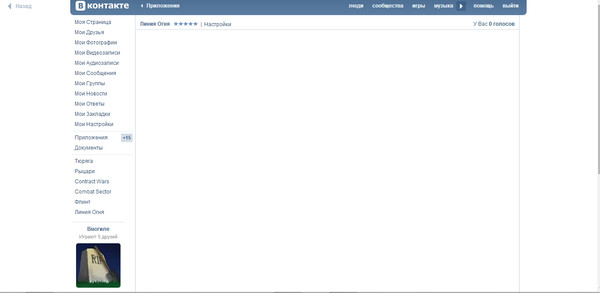

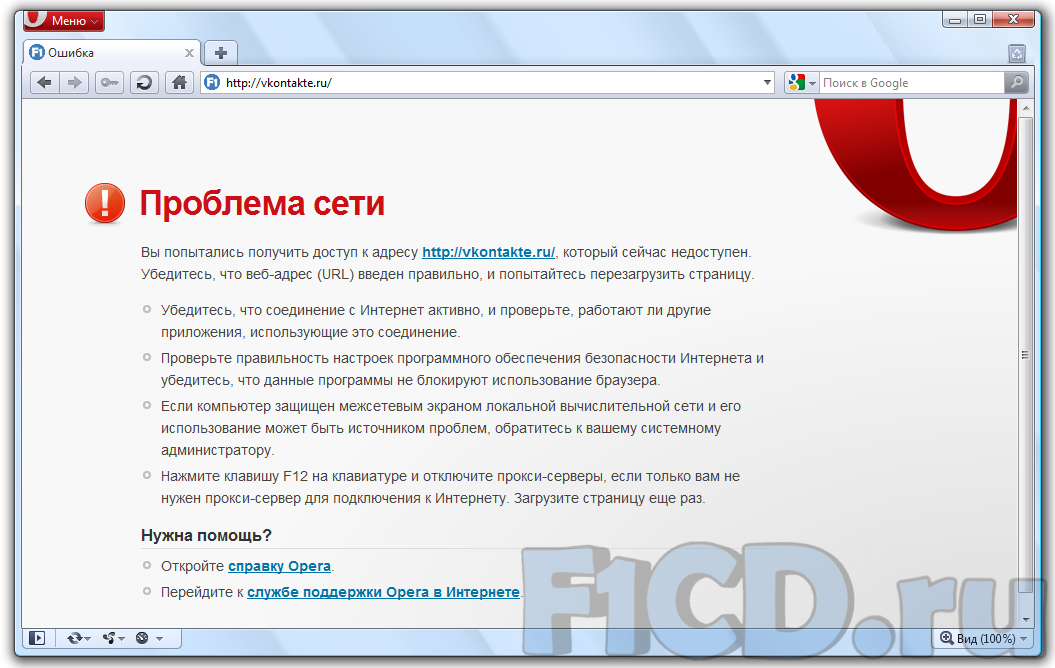

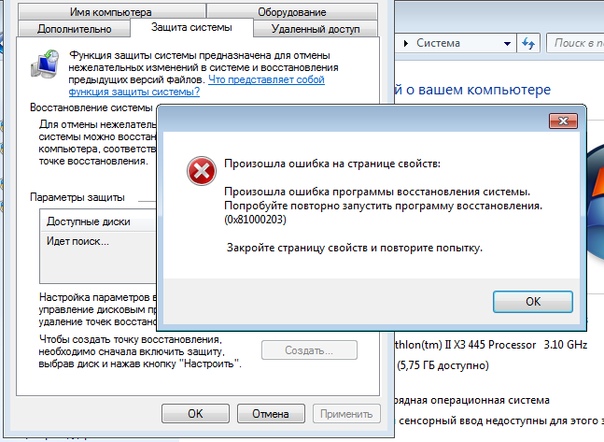

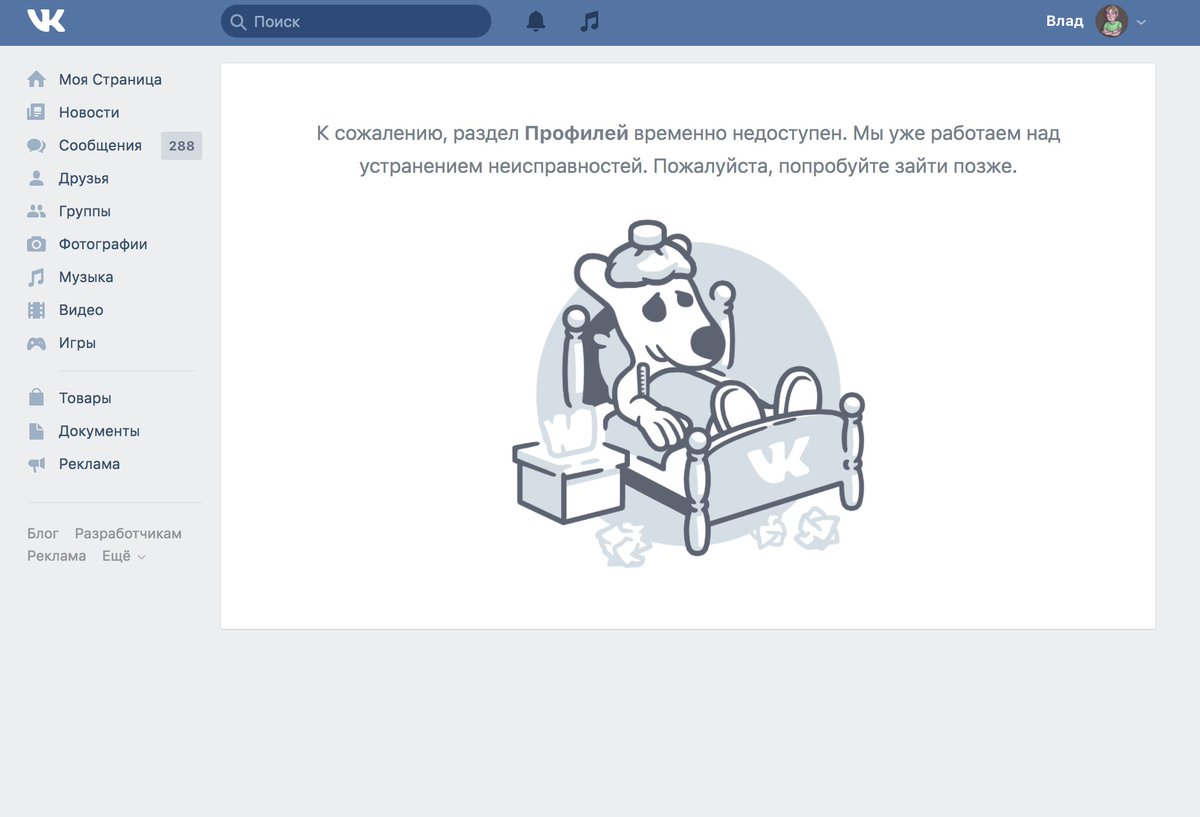

При переходе на свою страницу она не грузится ни с компьютера, ни с телефона. На экране появляется грустный смаил как на картинке ниже. Из – за чего же это случается? Это происходит из – за огромные количества людей, которые все время заходят на платформу и майнит. Иногда случается такой перегруз, что сайт просто не в силах справится и «слетает» на некоторое время, то есть перестает работать.

Что-то пошло не такЧто делать в такой ситуации?

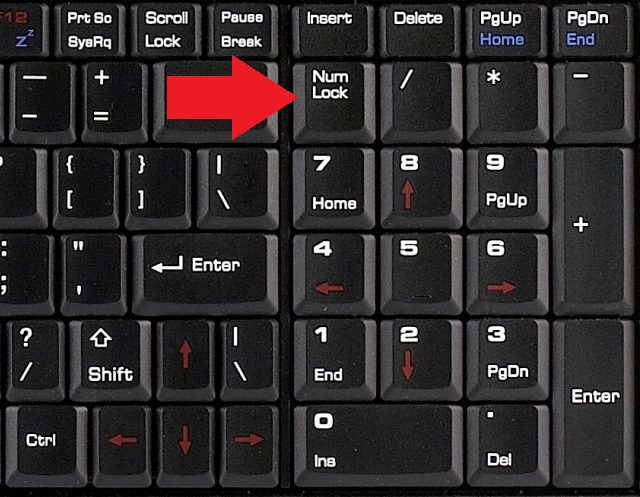

- Если проблема не в вашем устройстве, то нужно просто подождать. У нас тоже такое случалось, спустя пол часа вход снова стал доступен. Это стандартные системные сбои, тем более приложение новое;

- Если неполадки в вашем смартфоне, тогда следует заняться очисткой кэша. Таким образом вы удалите все то, что захламляет вашу память и мешает другим приложениям работать.

- Посмотрите не требуется ли вашему телефону обновить версию Вконтакте. Сделать это можно в зависимости от телефона в PlayMarket, AppStore, приложения и друге.

- Просто перезайдите в приложения, иногда случаются такие небольшие глюки. Если все в норме, то не обращайте внимания на это;

- Меняем время, возможно у вас в настройках не ваш часовой пояс? Это нужно изменить или все приложения, которые есть на вашем смартфоне не смогут работать в обычном режиме. Даже если и получится, потому будет происходит множество новых ошибок.

Возможные варианты решения

Интернет-соединение

Убедитесь, что ваше устройство может подключаться к Интернету. Если он не может подключиться, приложения не будут работать.

Переустановка

Вы можете попробовать полностью удалить приложение Вконтакте, а затем переустановить из магазина Google Play. Просто откройте приложение Play Store, откройте строку меню слева и нажмите Мои приложения и игры . Найдите ВК и нажмите «Удалить» — это займет несколько секунд. После этого вы можете установить его снова.

Перезагрузка

Вы также можете просто перезагрузить ваш смартфон. Это очень простой и довольно эффективной способ, если ваш телефон был включен в течение длительного времени.

Это очень простой и довольно эффективной способ, если ваш телефон был включен в течение длительного времени.

Рекомендуется выключать телефон каждые несколько дней на несколько минут — это поможет вашему телефону с множеством проблем, связанных с запуском приложений.

Полный сброс

Если вышеуказанные решения не помогли, вы можете вернуться к заводским настройкам телефона. Выполняя сброс к заводским настройкам, убедитесь, что вы сделали резервные копии всех своих данных заранее.

Я повторяю: сначала сделайте резервную копию всех ваших данных . Сброс настроек приведет к стиранию вашего устройства и возврату к заводским настройкам по умолчанию. Вы можете легко восстановить ваши приложения и данные, если вы сделали резервную копию.

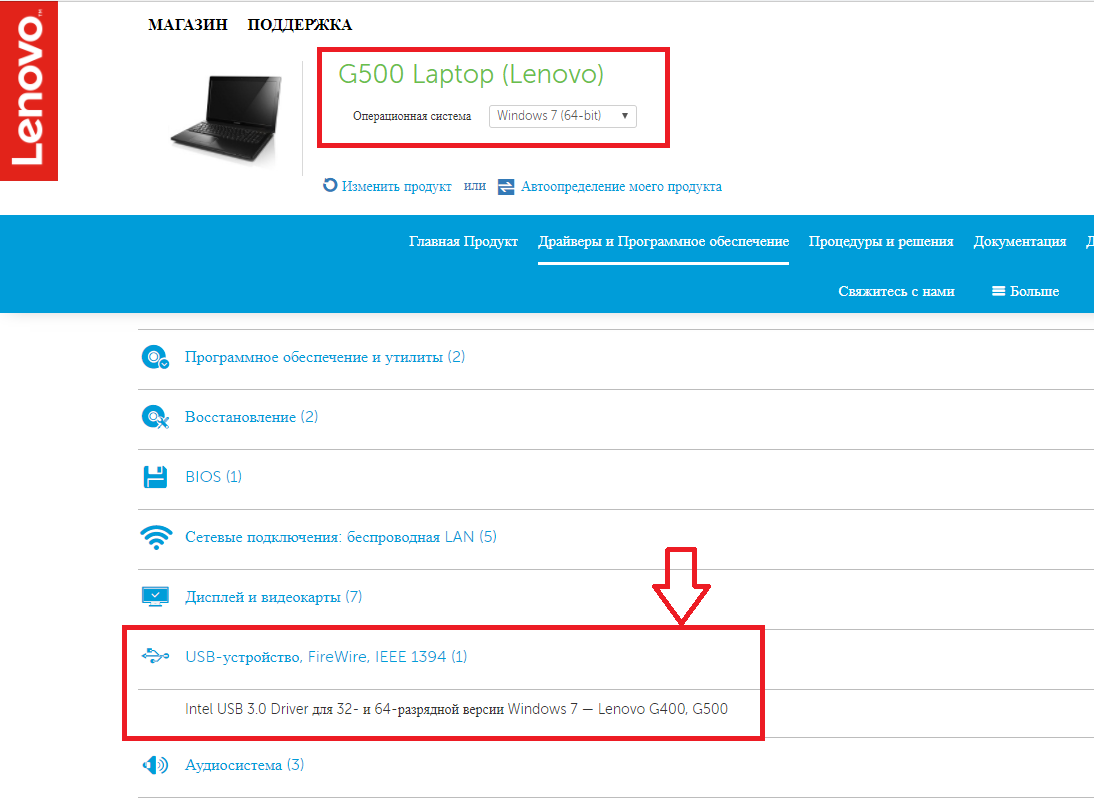

VK Coin к сожалению ваше устройство не поддерживается

Ниже приведены различные методы, которые могут помочь вам легко исправить ошибку «к сожалению ваше устройство не поддерживается».

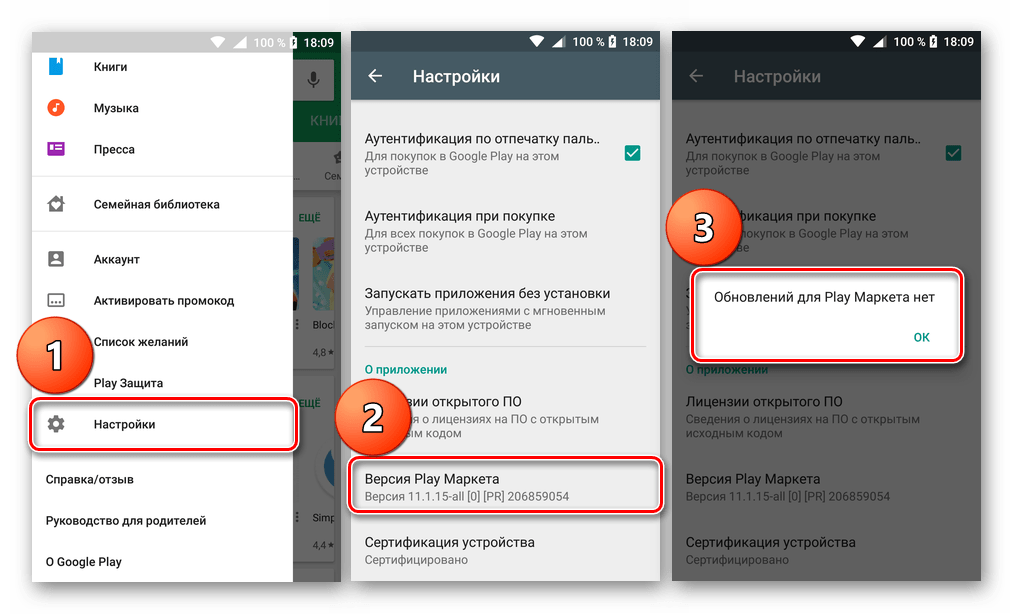

- Зайдите в Настройки на вашем устройстве.

- Нажмите «Диспетчер приложений».

- Найдите «Google Play Store» и нажмите на то же самое.

- Нажмите на кнопку «Удалить обновления».

- Нажмите на кнопку «ОК».

Это удалит все последние обновления в Google Play Store, которые могут быть причиной ошибки.

Еще как вариант:

Просто скачайте любое приложение VPN, предпочтительно Touch VPN установите и запустите.

Заключение:

Сегодня мы рассказали о решении проблемы vk coin, что делать, если он не хочет запускаться. Надеемся, что статья была для вас полезной. Если это так, то напишите нам об этом ниже, спасибо, что читаете нас.

Почему моя модель ML не работает?

Дата публикации Sep 23, 2019

Изучая курс машинного обучения, вы легко внедряете и тестируете модели машинного обучения в курсовых проектах. Все работает хорошо Однако в реальных сценариях ваша модель просто приводит к бессмысленным результатам, и вы можете быть не уверены, в чем проблема.

Все работает хорошо Однако в реальных сценариях ваша модель просто приводит к бессмысленным результатам, и вы можете быть не уверены, в чем проблема.

В этой статье я обсуждаю три компонента, которые должны быть соизмеримы друг с другом, чтобы модель ML работала:сложность проблемы, сложность модели и размер выборки, Как специалист по обработке данных, мы несем ответственность за определение и идентификацию каждого из компонентов. Мы определяем ясную проблему, определяем модель и решаем, нужно ли нам больше данных.

В оставшейся части этой статьи я рассмотрю каждый из этих компонентов в отдельности, а затем рассмотрю различные сценарии, за которыми последуют некоторые предложения.

Сложность проблемы, сложность модели и размер выборки должны совпадать.В некоторых случаях проблема может быть неясной, и нам может потребоваться определить точную проблему самостоятельно. Это первый шаг, и хорошее начало всегда дает хороший конец. Постарайтесь определить проблему как можно проще и в то же время убедиться, что она решит бизнес-задачу. Вот два примера, чтобы прояснить обсуждение:

Вот два примера, чтобы прояснить обсуждение:

а) Предположим, вам дали проект видеонаблюдения, где камера записывает кадры комнаты. Задача состоит в том, чтобы определить, есть ли кто-то в комнате или нет. Один из подходов заключается в развертывании алгоритма обнаружения человека на видеоданных. Второй подход заключается в обнаружении любого движения в видео, поскольку вы знаете, что движение в комнате может быть вызвано только человеком. Второй подход намного проще, чем первый, и ожидается, что более простая модель даст желаемые результаты.

б) Сложность проблемы заключается в том, насколько разнообразными могут быть данные. Поэтому, если у нас меньшее количество измерений, проблема будет менее сложной.

Предположим алгоритм классификации документов, в котором вы хотите классифицировать официальные документы. Первый подход заключается в применении подхода, основанного на видении, который учитывает каждый пиксель документа. Другой подход — посмотреть на текст в документах. Если документы содержат другой текст, то они различимы по тексту. Сложность проблемы во втором подходе намного меньше, чем в первом подходе, потому что текст имеет меньший размер по сравнению с изображением. Низкий размер означает меньшую гибкость и меньшую сложность.

Если документы содержат другой текст, то они различимы по тексту. Сложность проблемы во втором подходе намного меньше, чем в первом подходе, потому что текст имеет меньший размер по сравнению с изображением. Низкий размер означает меньшую гибкость и меньшую сложность.

Сложность модели может быть выведена изколичество весовэто должно быть установлено на этапе обучения. Если модель включает в себя большое количество весов внутри, то она более гибкая для изучения вещей. В свою очередь, вам нужно больше данных для обучения модели.

Давайте посмотрим несколько примеров:

а) Модель глубокого обучения с 3 входами и одним скрытым слоем с десятью нейронами, имеет около 50 весов.

б) Дерево решений с глубиной 4 имеет 15 весов (пороги рассматриваются как весовые коэффициенты).

в) Модель линейной регрессии для 3 входов имеет 4 веса.

Специалисты по данным должны иметь некоторые знания о различных алгоритмах, которые он или она использует. Если вы знаете, как работает алгоритм, у вас есть представление о количестве весов и сложности алгоритма. В этом случае вам не нужно тратить время на передачу небольших данных в сложную модель.

В этом случае вам не нужно тратить время на передачу небольших данных в сложную модель.

В следующем разделе я дам несколько советов о количестве выборок, основанных на количестве весов.

Это самый важный компонент, который необходимо учитывать при разработке модели ML. Я видел много случаев, когда размер выборки слишком мал, но инженеры машинного обучения тратят время на развертывание различных моделей и параметров настройки. В некоторых случаях для обучения достаточно нескольких сотен образцов, в то время как в других модель не может учиться на тысячах образцов.

Рассматривая три компонента, теперь пришло время проверить, достаточно ли у вас данных для указанной модели ML и проблемы.

Правильное количество образцов — открытая проблема. Никто не может сказать, сколько образцов необходимо для обучения модели без анализа данных. Это основано больше на опыте. Однако очень важно иметь ощущение правильного диапазона. В середине встречи вас могут спросить о приблизительном количестве необходимых вам образцов. Ваш ответ 100, 10000 или 1000000?

Ваш ответ 100, 10000 или 1000000?

Здесь я собираюсь дать вам несколько советов по оценке правильного количества образцов.

Количество весов в модели, которые представляют сложность модели, не должно превышать количество выборок. Подумайте о простой задаче линейной регрессии, которая имеет 10 весов (9 функций), и у вас есть 8 выборок. С математической точки зрения существуют бесконечные линейные модели, которые соответствуют образцам. По моему опыту, количество образцов должно быть как минимум в десять раз больше, чем количество функций Это означает, что для обучения регрессионной модели с 10 функциями нам нужно как минимум 100 выборок. Помните, что число десять основано на опыте, и этому нет никаких доказательств, поскольку оно зависит от характеристик данных. В нашем примере, если данные имеют линейную характеристику, мы можем обучить нашу модель меньшему количеству выборок. Кроме того, если все образцы выглядят одинаково, нам нужно больше, чтобы иметь более надежную модель. Есть и другие параметры, которые влияют на правильное количество образцов. Однако, учитывая количество весов в модели, вы получите подсказку о количестве образцов, которые вам примерно необходимы.

Есть и другие параметры, которые влияют на правильное количество образцов. Однако, учитывая количество весов в модели, вы получите подсказку о количестве образцов, которые вам примерно необходимы.

Исходя из состояния каждого параметра, у нас есть 8 различных сценариев. На рисунках 1 и 2 показан пример графика для каждого сценария. Я буду обсуждать каждый сценарий отдельно.

Малый размер выборки:Если количество выборок слишком мало, лучше подумать о модели на основе правил, а не обучать модели ML. Вообще говоря, используя менее 50 образцов, мы не используем модель ML.

a) Сложность модели = низкая, сложность проблемы = низкая, размер выборки = малая: это единственный случай, когда вы можете получить значимый результат, когда у вас недостаточно данных. Если проблема не сложная, выберите простую модель и обучите ее этим образцам.

б) Сложность модели = Высокая, Сложность проблемы = Низкая, Размер выборки = Маленький: Вы должны выбрать более простую модель, поскольку сложность модели должна соответствовать сложности задачи и размеру выборки. Даже если вы получаете более высокую производительность от очень сложной модели, простая модель работает лучше для невидимых данных. Причина в том, что оценка основана только на небольшом количестве данных, которые не являются надежными, и, настраивая параметры сложной модели, вы, вероятно, превосходите модель. Простая модель была бы более надежной на практике.

Даже если вы получаете более высокую производительность от очень сложной модели, простая модель работает лучше для невидимых данных. Причина в том, что оценка основана только на небольшом количестве данных, которые не являются надежными, и, настраивая параметры сложной модели, вы, вероятно, превосходите модель. Простая модель была бы более надежной на практике.

c) Сложность модели = низкая, сложность проблемы = высокая, размер выборки = малая: если это возможно, попытайтесь решить подзадачу или более простую версию проблемы. По крайней мере, вы можете достичь значимого результата.

d) Сложность модели = высокая, сложность проблемы = высокая, размер выборки = малая: даже если вы получите высокую точность, модель потерпит неудачу в реальной ситуации при работе с невидимыми данными.

Большой размер выборки:Наличие достаточного количества образцов является ключом к созданию хорошей модели ML. Следует отметить, что образцы не должны быть смещены. В противном случае нет большой разницы между маленькими и большими размерами выборки.

e) Сложность модели = низкая, сложность проблемы = низкая, размер выборки = большой: выбор модели не является большой проблемой со сложной проблемой и большим размером выборки. Большинство моделей ML дают хороший результат.

f) Сложность модели = высокая, сложность проблемы = низкая, размер выборки = большая: сложная модель может дать несколько лучший результат по сравнению с типичной моделью. Учитывая простоту объяснения и обслуживания модели, вы можете выбрать более простую модель.

g) Сложность модели = низкая, сложность проблемы = высокая, размер выборки = большая: если вам нравится работать с самыми современными методами, это подходящий вариант для вас. Выберите сложную модель (например, глубокое обучение), и вы получите желаемый результат.

h) Сложность модели = высокая, сложность задачи = высокая, размер выборки = большая: в этом случае вы можете увидеть всю мощь и красоту машинного обучения. Волшебство здесь происходит.

То, что я написал в этой статье, основано исключительно на моем опыте работы с моделями ML. Вы никогда не найдете их в курсе или книге, потому что это качественные понятия. Все данные разные, и вы не можете сформулировать количество необходимых данных. У вас не может быть правила выбора лучшей модели без анализа данных. Однако на практике очень важно иметь приблизительное понимание каждого из трех компонентов, обсуждаемых в этой статье. Это поможет вам принять правильные меры для исправления модели ML, когда она не работает.

Вы никогда не найдете их в курсе или книге, потому что это качественные понятия. Все данные разные, и вы не можете сформулировать количество необходимых данных. У вас не может быть правила выбора лучшей модели без анализа данных. Однако на практике очень важно иметь приблизительное понимание каждого из трех компонентов, обсуждаемых в этой статье. Это поможет вам принять правильные меры для исправления модели ML, когда она не работает.

Как всегда, я очень благодарен всем, кто читает мои работы, и я надеюсь, что вам понравится это! Если у вас есть какие-либо вопросы или комментарии, не стесняйтесь оставлять свои отзывы ниже, или вы можете связаться со мной поLinkedIn,

Оригинальная статья

Mobile Legends Bang Bang не загружается: проблемы с Mobile Legends Bang Bang

Главная »Проблемы» Mobile Legends Bang Bang не загружается: проблемы с Mobile Legends Bang Bang

Это может сильно раздражать, когда приложение из App Store не может быть загружено и, таким образом, обновлено. Загрузка или обновление начаты, но через несколько часов загружается только часть приложения.

Между прочим, могут возникать и другие проблемы и ошибки, которые вы можете найти в обзоре всех проблем Mobile Legends Bang Bang, найденных .

Mobile Legends Bang Bang не загружается

Вы хотите загрузить или обновить Mobile Legends Bang Bang, и загрузка или загрузка приложения занимает целую вечность, потому что оно просто не загружается. Многие потом отчаянно пытаются перезапустить загрузку Mobile Legends Bang Bang, но это тоже не приводит ни к какому полезному результату.

Следующей попыткой многих будет проверка интернет-соединения. Но WLAN показывает полный прием и все равно не работает или работает очень медленно.

Mobile Legends Bang Bang загружается очень медленно

Если Mobile Legends Bang Bang загружается очень медленно, это также может быть связано с размером самого приложения. Индикатор выполнения показывает медленную загрузку, но это может появиться только из-за размера приложения. В случае обновления вы можете проверить в соответствующем магазине приложений, насколько велик установочный файл, и узнать, может ли он загружаться так долго из-за своего размера.

Mobile Legends Bang Bang Обновление не запускается

Хотите ли вы обновить Mobile Legends Bang Bang или загрузить его снова.Если одно не работает, вероятно, у вас те же проблемы с другим, и вам следует искать те же решения.

Поэтому мы собрали несколько возможных решений, чтобы вы могли без проблем загрузить приложение Mobile Legends Bang Bang.

Для того, чтобы Mobile Legends Bang Bang скачать для работы:

Мы надеемся, что следующие решения помогут вам загрузить Mobile Legends Bang Bang, и загрузка не займет много времени. Если вам известны другие возможные решения, мы с нетерпением ждем сообщения от вас в конце этой статьи.

Если вам известны другие возможные решения, мы с нетерпением ждем сообщения от вас в конце этой статьи.

- Проверьте подключение к Интернету

Причины, по которым Mobile Legends Bang Bang не может быть загружен, не могут быть более разными. В большинстве случаев это связано с вашим собственным подключением к Интернету. Вполне возможно, что ваше устройство подключено к сети Wi-Fi, но оно по-прежнему не работает, поэтому вам следует попытаться получить доступ к веб-сайту в Интернете с помощью браузера. Если все работает нормально, значит, это не ваш смартфон или планшет. Если вы попытаетесь загрузить приложение через мобильную сеть

- Перезагрузите смартфон или планшет

Часто возникают проблемы с App Store после обновления операционной системы Android или iOS. После обновления системы вполне может случиться так, что соединение с данными для входа в соответствующий магазин больше не будет надежно работать.В этом случае вам следует перезагрузить смартфон или планшет, что перезагрузит все настройки и функции и, при необходимости, восстановит соединение с App Store.

Если перезапуск и рабочее интернет-соединение не помогли решить проблему, а Mobile Legends Bang Bang по-прежнему загружается медленно или не загружается вообще, то это также может быть на серверах iTunes Store для iOS или Android. на серверах Google Play Store лежат. Это не должно быть связано с серверами разработчика Moonton, поскольку приложение находится на серверах App Store, в редких случаях они могут быть перегружены или возникать сбои из-за работ по техническому обслуживанию.

проверить статус сервера Apple

проверить статус сервера Google- Для Android: Очистите кеш и удалите данные в Play Store.

- Откройте на устройстве приложение « Настройки ».

- Коснитесь Приложения и уведомления , затем щелкните Просмотреть все приложения .

- Прокрутите вниз и коснитесь Google Play Store.

- Tap Память Пустой кеш .

- Затем нажмите Очистить данные .

- Снова откройте Play Store и повторите попытку загрузки.

Итак, мы надеемся, что советы и рекомендации были полезны, и загрузка Mobile Legends Bang Bang снова работает быстро и без каких-либо проблем.

Если у вас по-прежнему возникают проблемы, а Mobile Legends Bang Bang по-прежнему загружается медленно, мы с нетерпением ждем вашего ответа.

Mobile Legends Bang Bang Сообщить о проблемеАналогичные выпуски Mobile Legends Bang Bang:

Подобные сообщения:

Mobile Legends Bang Bang не загружается или работает медленно? Сообщите здесь:

Почему моя модель ML не работает ?. Подсказка: сложность модели, проблема… | by Amin Sadri

Изучая курс машинного обучения, вы легко развертываете и тестируете модели машинного обучения в курсовых проектах. Все работает хорошо. Однако в реальных сценариях ваша модель просто дает бессмысленные результаты, и вы можете не знать, в чем проблема.

В этой статье я обсуждаю три компонента, которые должны быть соизмеримы друг с другом, чтобы модель машинного обучения работала: сложность задачи , сложность модели и размер выборки . Как специалист по данным, мы несем ответственность за определение и идентификацию каждого из компонентов. Мы определяем четкую проблему, определяем модель и решаем, нужны ли нам дополнительные данные.

Мы определяем четкую проблему, определяем модель и решаем, нужны ли нам дополнительные данные.

В оставшейся части статьи я рассмотрю каждый из этих компонентов по отдельности, а затем исследую различные сценарии с последующими некоторыми предложениями.

Сложность задачи, сложность модели и размер выборки должны соответствовать.В некоторых случаях проблема может быть неясной, и нам может потребоваться определить точную проблему самостоятельно. Это первый шаг, и хорошее начало всегда делает хороший конец. Постарайтесь определить проблему как можно проще и в то же время убедитесь, что она решит бизнес-задачу. Вот два примера, чтобы прояснить обсуждение:

a) Предположим, вам дается проект видеонаблюдения, в котором камера записывает кадры комнаты.Задача — определить, есть ли кто-нибудь в комнате или нет. Один из подходов — применить алгоритм обнаружения человека к видеоданным. Второй подход — обнаружить любое движение на видео, поскольку вы знаете, что движение в комнате может быть вызвано только человеком. Второй подход намного проще первого, и ожидается, что более простая модель даст желаемые результаты.

Второй подход намного проще первого, и ожидается, что более простая модель даст желаемые результаты.

б) Сложность проблемы заключается в том, насколько разнообразными могут быть данные. Следовательно, чем меньше размерностей, тем сложнее проблема.

Предположим, алгоритм классификации документов, в котором вы хотите классифицировать официальные документы. Первый подход заключается в применении подхода, основанного на видении, который учитывает каждый пиксель документа. Другой подход — посмотреть текст в документах. Если документы содержат разный текст, они различимы по тексту. Сложность проблемы во втором подходе намного меньше, чем сложность в первом подходе, потому что текст имеет небольшую размерность по сравнению с изображением.Низкие размеры означают меньшую гибкость и меньшую сложность.

Сложность модели может быть выведена из числа весов , которые должны быть установлены на этапе обучения. Если модель включает в себя большое количество грузов, она более гибкая для изучения вещей. Взамен вам нужно больше данных для обучения модели.

Взамен вам нужно больше данных для обучения модели.

Давайте посмотрим на несколько примеров:

a) Модель глубокого обучения с 3 входами и одним скрытым слоем с десятью нейронами имеет около 50 весов.

b) Дерево решений с глубиной 4 имеет 15 весов (пороги считаются весами).

c) Модель линейной регрессии для 3 входных данных имеет 4 веса.

Специалисты по обработке данных должны иметь некоторое представление о различных алгоритмах, которые он использует. Если вы знаете, как работает алгоритм, у вас есть некоторое представление о количестве весов и сложности алгоритма. В этом случае вам не нужно будет тратить время на ввод данных в сложную модель.

В следующем разделе я дам несколько подсказок о количестве выборок в зависимости от количества весов.

Это наиболее важный компонент, который следует учитывать при разработке модели машинного обучения.Я видел много случаев, когда размер выборки слишком мал, но инженеры по машинному обучению тратят время на развертывание различных моделей и настройку параметров. В некоторых случаях для обучения достаточно нескольких сотен образцов, в то время как в других модель не может учиться на тысячах образцов.

В некоторых случаях для обучения достаточно нескольких сотен образцов, в то время как в других модель не может учиться на тысячах образцов.

Рассматривая три компонента, теперь пора проверить, достаточно ли у вас данных для указанной модели машинного обучения и проблемы.

Правильное количество образцов — открытая проблема. Никто не может сказать, сколько образцов необходимо для обучения модели, не анализируя данные.Это больше основано на опыте. Однако очень важно иметь чувство правильного диапазона. В середине встречи вас могут спросить о примерном количестве необходимых вам образцов. Ваш ответ 100, 10000 или 1000000?

Здесь я дам вам несколько советов по оценке правильного количества образцов.

Количество весов в модели, которые представляют сложность модели, не должно быть больше количества выборок. Подумайте о простой задаче линейной регрессии, которая имеет 10 весов (9 признаков) и у вас есть 8 выборок.С математической точки зрения существует бесконечное количество линейных моделей, которые соответствуют образцам. По моему опыту, количество образцов должно быть как минимум в десять раз больше, чем количество функций. Это означает, что для обучения регрессионной модели с 10 функциями нам понадобится не менее 100 образцов. Помните, что число десять основано на опыте, и для этого нет никаких доказательств, поскольку оно зависит от характеристик данных. В нашем примере, если данные имеют линейную характеристику, мы можем обучить нашу модель с меньшим количеством выборок.Кроме того, если все образцы выглядят одинаково, нам нужно больше, чтобы иметь более надежную модель. Есть также другие параметры, которые способствуют правильному количеству выборок. Однако рассмотрение количества гирь в модели дает вам подсказку о количестве образцов, которые вам примерно нужны.

По моему опыту, количество образцов должно быть как минимум в десять раз больше, чем количество функций. Это означает, что для обучения регрессионной модели с 10 функциями нам понадобится не менее 100 образцов. Помните, что число десять основано на опыте, и для этого нет никаких доказательств, поскольку оно зависит от характеристик данных. В нашем примере, если данные имеют линейную характеристику, мы можем обучить нашу модель с меньшим количеством выборок.Кроме того, если все образцы выглядят одинаково, нам нужно больше, чтобы иметь более надежную модель. Есть также другие параметры, которые способствуют правильному количеству выборок. Однако рассмотрение количества гирь в модели дает вам подсказку о количестве образцов, которые вам примерно нужны.

В зависимости от статуса каждого параметра у нас есть 8 различных сценариев. На рисунках 1 и 2 показан пример графика для каждого сценария. Я расскажу о каждом сценарии отдельно.

Маленький размер выборки: Если количество выборок слишком мало, лучше подумать о модели, основанной на правилах, а не обучать модель машинного обучения. Вообще говоря, с менее чем 50 образцами мы не используем модель машинного обучения.

Вообще говоря, с менее чем 50 образцами мы не используем модель машинного обучения.

a) Сложность модели = низкая, сложность проблемы = низкая, размер выборки = небольшой: это единственный случай, когда вы можете получить значимый результат, когда у вас недостаточно данных. Если проблема несложная, выберите простую модель и обучите ее этим образцам.

b) Сложность модели = высокая, сложность задачи = низкая, размер выборки = небольшой: вам следует выбрать более простую модель, поскольку сложность модели должна быть соизмеримой со сложностью задачи и размером выборки.Даже если вы получите более высокую производительность от очень сложной модели, простая модель лучше работает с невидимыми данными. Причина в том, что оценка основана только на небольшом количестве данных, которые не являются надежными, и, настраивая параметры сложной модели, вы, вероятно, переобучите модель. На практике простая модель была бы более надежной.

c) Сложность модели = низкая, сложность проблемы = высокая, размер выборки = небольшой: если возможно, попробуйте решить подзадачу или более простой вариант проблемы. По крайней мере, можно добиться значимого результата.

По крайней мере, можно добиться значимого результата.

d) Сложность модели = высокая, сложность проблемы = высокая, размер выборки = малый: даже если вы получите высокую точность, модель выйдет из строя в реальной ситуации при работе с невидимыми данными.

Большой размер выборки: Наличие достаточного количества выборок — ключ к созданию хорошей модели машинного обучения. Следует отметить, что выборки не должны быть предвзятыми. В остальном разница между малым и большим размером выборки невелика.

e) Сложность модели = низкая, сложность проблемы = низкая, размер выборки = большой: выбор модели не является большой проблемой при сложной проблеме и большом размере выборки.Большинство моделей машинного обучения дают хороший результат.

f) Сложность модели = высокая, сложность проблемы = низкая, размер выборки = большой: сложная модель может дать немного лучший результат по сравнению с типичной моделью. Учитывая объяснимость и поддержку модели, вы можете выбрать более простую модель.

g) Сложность модели = низкая, сложность проблемы = высокая, размер выборки = большой: если вам нравится работать с современными методами, это подходящий случай. Выберите сложную модель (например,глубокое обучение), и вы получите желаемый результат.

h) Сложность модели = высокая, сложность проблемы = высокая, размер выборки = большой: в этом случае вы можете убедиться в силе и красоте машинного обучения. Здесь происходит волшебство.

То, что я написал в этой статье, основано исключительно на моем опыте работы с моделями машинного обучения. Вы никогда не найдете их в курсе или книге, потому что это качественные концепции. Все данные разные, и вы не можете сформулировать количество требуемых данных. У вас не может быть правила для выбора лучшей модели без анализа данных.Однако на практике очень важно иметь общее представление о каждом из трех компонентов, обсуждаемых в этой статье. Это поможет вам предпринять правильные действия по исправлению вашей модели машинного обучения, когда она не работает._2005_2011_kopia/000/003_m-class-5.jpg)

Как всегда, я очень благодарен всем, кто читает мои работы, и надеюсь, вам понравится эта работа! Если у вас есть какие-либо вопросы или комментарии, не стесняйтесь оставлять свои отзывы ниже или вы можете связаться со мной через LinkedIn.

Настройка обучающего прогона — Машинное обучение Azure

- Статья .

- 10 минут на чтение

Оцените свой опыт

да Нет

Любой дополнительный отзыв?

Отзыв будет отправлен в Microsoft: при нажатии кнопки «Отправить» ваш отзыв будет использован для улучшения продуктов и услуг Microsoft.Политика конфиденциальности.

Представлять на рассмотрение

Спасибо.

В этой статье

Из этой статьи вы узнаете, как настроить и отправить прогоны машинного обучения Azure для обучения ваших моделей. Фрагменты кода объясняют ключевые части настройки и отправки обучающего скрипта. Затем используйте один из примеров записных книжек, чтобы найти полные сквозные рабочие примеры.

Обычно обучение начинается на локальном компьютере, а затем выполняется масштабирование до облачного кластера. С помощью машинного обучения Azure вы можете запускать сценарий на различных целевых объектах вычислений, не изменяя сценарий обучения.

Все, что вам нужно сделать, это определить среду для каждого целевого объекта вычислений в конфигурации запуска сценария . Затем, если вы хотите запустить свой обучающий эксперимент на другом целевом объекте вычислений, укажите конфигурацию запуска для этого вычисления.

Предварительные требования

Что такое конфигурация запуска сценария?

ScriptRunConfig используется для настройки информации, необходимой для отправки обучающего прогона как части эксперимента.

Вы отправляете свой обучающий эксперимент с объектом ScriptRunConfig. Этот объект включает:

- source_directory : исходный каталог, содержащий ваш обучающий сценарий

- сценарий : обучающий сценарий для запуска

- compute_target : цель вычислений для запуска на

- среда : среда, используемая при запуске сценария

- и некоторые дополнительные настраиваемые параметры (дополнительную информацию см. В справочной документации)

Обучите свою модель

Шаблон кода для отправки обучающего прогона одинаков для всех типов вычислительных целей:

- Создать эксперимент для запуска

- Создать среду, в которой будет запускаться сценарий

- Создайте ScriptRunConfig, который указывает цель вычислений и среду

- Отправить пробег

- Дождитесь завершения прогона

Или вы можете:

Создать эксперимент

Создайте эксперимент в своем рабочем пространстве. Experiemnt — это легкий контейнер, который помогает организовать отправку запусков и отслеживать код.

Experiemnt — это легкий контейнер, который помогает организовать отправку запусков и отслеживать код.

из эксперимента по импорту azureml.core

эксперимент_имя = 'мой_эксперимент'

эксперимент = эксперимент (рабочая область = ws, имя = имя_эксперимента)

Выберите цель вычислений

Выберите цель вычислений, на которой будет выполняться ваш обучающий сценарий. Если цель вычислений не указана в ScriptRunConfig или compute_target = 'local' , Azure ML выполнит ваш сценарий локально.

В примере кода в этой статье предполагается, что вы уже создали цель вычислений my_compute_target из раздела «Предварительные требования».

Примечание

Azure Databricks не поддерживается в качестве целевого объекта вычислений для обучения модели. Вы можете использовать Azure Databricks для подготовки данных и задач развертывания.

Создать среду

Среды машинного обучения Azure — это инкапсуляция среды, в которой происходит обучение машинному обучению. Они определяют пакеты Python, образ Docker, переменные среды и настройки программного обеспечения для ваших сценариев обучения и оценки. Они также определяют время выполнения (Python, Spark или Docker).

Они определяют пакеты Python, образ Docker, переменные среды и настройки программного обеспечения для ваших сценариев обучения и оценки. Они также определяют время выполнения (Python, Spark или Docker).

Вы можете определить свою собственную среду или использовать специально подобранную среду Azure ML. Курируемые среды — это предопределенные среды, доступные в вашем рабочем пространстве по умолчанию. Эти среды поддерживаются кэшированными образами Docker, что снижает затраты на подготовку к запуску. См. Полный список доступных настраиваемых сред в разделе «Курируемые среды машинного обучения Azure».

Для удаленных целевых вычислений вы можете использовать одну из этих популярных курируемых сред, чтобы начать с:

из azureml.core import Workspace, Environment

ws = Workspace.from_config ()

myenv = Environment.get (workspace = ws, name = "AzureML-Minimal")

Дополнительные сведения и сведения о средах см. В разделе Создание и использование программных сред в Машинном обучении Azure.

Локальная цель вычислений

Если вашей целью вычислений является ваш локальный компьютер , вы несете ответственность за обеспечение доступности всех необходимых пакетов в среде Python, в которой выполняется сценарий.Используйте python.user_managed_dependencies , чтобы использовать текущую среду Python (или Python по указанному вами пути).

из среды импорта azureml.core

myenv = Environment ("окружение, управляемое пользователем")

myenv.python.user_managed_dependencies = Истина

# Вы можете выбрать конкретную среду Python, указав путь к Python

# myenv.python.interpreter_path = '/ home / johndoe / miniconda3 / envs / myenv / bin / python'

Создайте конфигурацию запуска сценария

Теперь, когда у вас есть цель вычислений ( my_compute_target , см. Предварительные требования и среда ( myenv , см. Создание среды), создайте конфигурацию запуска сценария, которая запускает ваш обучающий сценарий ( train.), расположенный в вашем каталоге  py

py project_folder :

из azureml.core импорт ScriptRunConfig

src = ScriptRunConfig (исходный_каталог = папка_проекта,

script = 'train.py',

compute_target = my_compute_target,

среда = myenv)

# Установить цель вычислений

# Пропустите это, если вы работаете на локальном компьютере

script_run_config.run_config.target = my_compute_target

Если вы не укажете среду, для вас будет создана среда по умолчанию.

Если у вас есть аргументы командной строки, которые вы хотите передать своему обучающему сценарию, вы можете указать их с помощью параметра arguments конструктора ScriptRunConfig, например аргументов = ['- arg1', arg1_val, '--arg2', arg2_val] .

Если вы хотите изменить максимальное время, разрешенное по умолчанию для выполнения, вы можете сделать это с помощью параметра max_run_duration_seconds . Система попытается автоматически отменить запуск, если он займет больше времени, чем это значение.

Система попытается автоматически отменить запуск, если он займет больше времени, чем это значение.

Укажите конфигурацию распределенного задания

Если вы хотите запустить распределенное задание по обучению, укажите конфигурацию распределенного задания для параметра distribution_job_config . Поддерживаемые типы конфигурации включают MpiConfiguration, TensorflowConfiguration и PyTorchConfiguration.

Для получения дополнительной информации и примеров по запуску распределенных заданий Horovod, TensorFlow и PyTorch см .:

Провести эксперимент

запустить = эксперимент.отправить (config = src)

run.wait_for_completion (show_output = True)

Важно

Когда вы отправляете тренировочный прогон, создается моментальный снимок каталога, который содержит ваши обучающие сценарии, и он отправляется в цель вычислений. Он также сохраняется как часть эксперимента в вашем рабочем пространстве. Если вы измените файлы и снова отправите запуск, будут загружены только измененные файлы.

Если вы измените файлы и снова отправите запуск, будут загружены только измененные файлы.

Чтобы предотвратить включение ненужных файлов в снимок, создайте файл игнорирования (.gitignore или .amlignore ) в каталоге. Добавьте в этот файл файлы и каталоги, которые нужно исключить. Дополнительные сведения о синтаксисе для использования в этом файле см. В разделе синтаксис и шаблоны для .gitignore . Файл .amlignore использует тот же синтаксис. Если существуют оба файла, используется файл .amlignore , а файл .gitignore не используется.

Для получения дополнительной информации о снимках см. Снимки.

Важно

Специальные папки Две папки, выводит и , журналы , получают особую обработку в Машинном обучении Azure.Во время обучения, когда вы записываете файлы в папки с именем , выходы и , журналы , относящиеся к корневому каталогу ( . и  /outputs

/outputs ./logs , соответственно), файлы автоматически загружаются в вашу историю запусков, поэтому что у вас есть доступ к ним после завершения вашего запуска.

Чтобы создавать артефакты во время обучения (например, файлы моделей, контрольные точки, файлы данных или изображения на графике), запишите их в папку ./outputs .

Точно так же вы можете записывать любые журналы с вашего тренировочного пробега на .Папка / logs . Чтобы использовать интеграцию TensorBoard Машинного обучения Azure, убедитесь, что вы записываете свои журналы TensorBoard в эту папку. Во время выполнения вы сможете запустить TensorBoard и транслировать эти журналы. Позже вы также сможете восстановить журналы любого из ваших предыдущих запусков.

Например, чтобы загрузить файл, записанный в папку , выводит , на локальный компьютер после запуска удаленного обучения: run.download_file (name = 'output / my_output_file', output_file_path = 'my_destination_path')

Отслеживание и интеграция Git

Когда вы запускаете обучающий прогон, где исходный каталог является локальным репозиторием Git, информация о репозитории сохраняется в истории прогона. Дополнительные сведения см. В разделе «Интеграция Git для машинного обучения Azure».

Дополнительные сведения см. В разделе «Интеграция Git для машинного обучения Azure».

Примеры ноутбуков

Примеры настройки запусков для различных сценариев обучения см. В этих записных книжках:

Узнайте, как запускать записные книжки, прочитав статью Использование записных книжек Jupyter для изучения этой службы.

Поиск и устранение неисправностей

AttributeError: объект ‘RoundTripLoader’ не имеет атрибута ‘comment_handling’ : Эта ошибка возникает из новой версии (v0.17.5) из

ruamel-yaml, зависимостиazureml-core, которая вносит критическое изменение вazureml-core. Чтобы исправить эту ошибку, удалитеruamel-yaml, запустивpip uninstall ruamel-yamlи установив другую версиюruamel-yaml; поддерживаемые версии: от v0.15.35 до v0.17.4 (включительно). Вы можете сделать это, запустивpip install "ruamel-yaml> = 0.15.35, <0.. 17.5"

17.5" Ошибка при выполнении

jwt.exceptions.DecodeError: точное сообщение об ошибке:jwt.exceptions.DecodeError: требуется, чтобы вы передали значение для аргумента «алгоритмы» при вызове decode ().Рассмотрите возможность обновления до последней версии azureml-core:

pip install -U azureml-core.Если вы столкнулись с этой проблемой при локальных запусках, проверьте версию PyJWT, установленную в вашей среде, в которой вы запускаете запуски. Поддерживаемые версии PyJWT: <2.0,0. Удалите PyJWT из среды, если версия> = 2.0.0. Вы можете проверить версию PyJWT, удалить и установить нужную версию следующим образом:

- Запустите командную оболочку, активируйте среду conda, в которой установлено azureml-core.

- Введите

pip freezeи найдитеPyJWT, если он найден, указанная версия должна быть <2.0.0 - Если указанная версия не является поддерживаемой,

pip удалите PyJWTв командной оболочке и введите y для подтверждения.

- Установить с помощью

pip install 'PyJWT <2.0.0'

Если вы отправляете среду, созданную пользователем, вместе с запуском, подумайте об использовании последней версии azureml-core в этой среде. Версии> = 1.18.0 azureml-core уже закрепили PyJWT <2.0.0. Если вам нужно использовать версию azureml-core <1.18.0 в отправляемой вами среде, обязательно укажите PyJWT <2.0.0 в зависимостях вашего пакета.

ModuleErrors (модуль не назван) : если вы запускаете ModuleErrors при отправке экспериментов в Azure ML, обучающий сценарий ожидает, что пакет будет установлен, но не добавлен.После того, как вы укажете имя пакета, Azure ML установит пакет в среде, используемой для вашего учебного прогона.

Если вы используете оценщики для отправки экспериментов, вы можете указать имя пакета с помощью параметра

pip_packagesилиconda_packagesв оценщике в зависимости от того, из какого источника вы хотите установить пакет. Вы также можете указать yml-файл со всеми своими зависимостями, используя

Вы также можете указать yml-файл со всеми своими зависимостями, используя conda_dependencies_file, или перечислить все ваши требования к pip в текстовом файле, используя параметрpip_requirements_file.Если у вас есть собственный объект среды машинного обучения Azure, который вы хотите переопределить изображение по умолчанию, используемое оценщиком, вы можете указать эту среду с помощью параметраenvironmentконструктора оценщика.Azure ML обслуживает образы докеров, и их содержимое можно увидеть в контейнерах AzureML. Зависимости, специфичные для фреймворка, перечислены в соответствующей документации фреймворка:

Примечание

Если вы считаете, что конкретный пакет достаточно распространен, чтобы его можно было добавить в образы и среды, поддерживаемые Azure ML, пожалуйста, поднимите проблему GitHub в контейнерах AzureML.

NameError (имя не определено), AttributeError (объект не имеет атрибута) : это исключение должно исходить из ваших обучающих сценариев.

Вы можете просмотреть файлы журнала на портале Azure, чтобы получить дополнительные сведения о том, что конкретное имя не определено, или об ошибке атрибута. Из SDK вы можете использовать

Вы можете просмотреть файлы журнала на портале Azure, чтобы получить дополнительные сведения о том, что конкретное имя не определено, или об ошибке атрибута. Из SDK вы можете использовать run.get_details (), чтобы просмотреть сообщение об ошибке. Здесь также будут перечислены все файлы журнала, созданные для вашего запуска. Обязательно ознакомьтесь со своим сценарием тренировки и исправьте ошибку перед повторной отправкой пробежки.Запуск или удаление эксперимента : Эксперименты можно заархивировать с помощью Experiment.archive или на вкладке «Эксперимент» в клиенте студии машинного обучения Azure с помощью кнопки «Архивировать эксперимент». Это действие скрывает эксперимент из списковых запросов и представлений, но не удаляет его.

Окончательное удаление отдельных экспериментов или прогонов в настоящее время не поддерживается. Дополнительные сведения об удалении ресурсов рабочей области см. В разделе Экспорт или удаление данных рабочей области службы машинного обучения.

Документ метрики слишком велик : Машинное обучение Azure имеет внутренние ограничения на размер объектов метрики, которые могут быть зарегистрированы сразу после прогона обучения. Если вы столкнулись с ошибкой «Документ метрики слишком большой» при регистрации метрики со списком, попробуйте разделить список на более мелкие части, например:

run.log_list ("имя моей метрики", my_metric [: N]) run.log_list ("название моей метрики", my_metric [N:])Внутри Azure ML объединяет блоки с одинаковым именем метрики в непрерывный список.

Запуск целевого объекта вычислений занимает много времени : образы Docker для целевых объектов вычислений загружаются из реестра контейнеров Azure (ACR). По умолчанию Машинное обучение Azure создает ACR, который использует базовый уровень обслуживания . Изменение ACR для рабочего пространства на стандартный или премиум-уровень может сократить время, необходимое для создания и загрузки образов.

Дополнительные сведения см. В разделе Уровни службы реестра контейнеров Azure.

Дополнительные сведения см. В разделе Уровни службы реестра контейнеров Azure.

Следующие шаги

Мобильные данные не работают? Вот несколько решений.

Наши смартфоны - незаменимые крошечные карманные компьютеры, но они стали настолько удобными, что мы почти не можем жить без них.Интернет-соединение - это основа работы со смартфоном, поэтому всякий раз, когда данные перестают работать, кажется, что мир останавливается. Что вы делаете, чтобы вернуться в сетку? Возможно, вы столкнулись с проблемой передачи данных по сотовой сети. Вот несколько решений для восстановления мобильных данных.

Читать далее: Вот как устранить и устранить наиболее распространенные проблемы Wi-Fi

Примечание редактора: Некоторые инструкции в этой статье были созданы с использованием Pixel 4a с 5G под управлением Android 12.Имейте в виду, что шаги могут немного отличаться в зависимости от используемого вами устройства.

Проверить, включен ли режим полета

В режиме полета отключаются все беспроводные антенны, включая мобильные данные, Wi-Fi и Bluetooth. Обычно его включают случайно (по крайней мере, со мной такое случается постоянно!). Идите и проверьте, случилось ли это с вами. Часто в быстрых настройках области уведомлений есть переключатель, но вы также можете сделать это в настройках.

Как включить / выключить режим полета:

- Откройте приложение Settings .

- Войдите в Сеть и Интернет .

- Ищите Режим полета . Рядом с ним будет переключатель. Нажмите на него, чтобы включить или выключить.

Кроме того, включение и выключение режима полета может сбросить настройки и вернуть все в нормальное состояние. Если ваш телефон не был в режиме полета, включите и выключите эту функцию и посмотрите, снова ли это заставит ваши данные работать.

А перезагрузку пробовали?

Каким бы необъяснимым это ни было, мы находим, что большинство проблем со смартфоном решаются простой перезагрузкой. Множество возможных расхождений может вызвать проблемы с вашими мобильными данными, и есть вероятность, что если вы здесь ищете ответы, проблема с телефоном будет немного сложнее, но не помешает напомнить вам попробовать старый добрый перезапуск. Это может сработать.

Множество возможных расхождений может вызвать проблемы с вашими мобильными данными, и есть вероятность, что если вы здесь ищете ответы, проблема с телефоном будет немного сложнее, но не помешает напомнить вам попробовать старый добрый перезапуск. Это может сработать.

Читайте также: Мой телефон не заряжается! Что я могу сделать?

Проверить свой план?

Edgar Cervantes / Android Authority

Некоторые тарифные планы мобильной передачи данных имеют ограничения и ограничения. Изучите условия своего плана и посмотрите, не было ли использовано больше данных, чем следовало бы.Вы можете быть ограничены или задушены. Также примите во внимание тот факт, что вы можете задержать платеж. Даже лучшие из нас иногда забывают о счетах. Не говоря уже о том, что иногда карты отклоняются без видимой причины.

Switch: Лучшие доступные безлимитные тарифные планы

Проверьте вашу SIM-карту

SIM-карты могут перемещаться, и иногда контакты могут выходить из строя. Если описанные выше действия вам не подходят, рекомендуется немного поиграть с SIM-картой. Вытащите и снова вставьте.Может, попробуй немного почистить? Не помешает попробовать! Это отличный способ снова заставить мобильные данные работать.

Если описанные выше действия вам не подходят, рекомендуется немного поиграть с SIM-картой. Вытащите и снова вставьте.Может, попробуй немного почистить? Не помешает попробовать! Это отличный способ снова заставить мобильные данные работать.

Это гугл?

Если конкретно приложения Google не работают с мобильными данными, есть небольшая вероятность, что это что-то связано с Search Giant. Попробуйте выполнить следующие действия, чтобы убедиться, что все вернется в норму.

- Очистите кеш в приложении "Сервисы Google Play": Настройки> Приложения> Просмотреть все приложения> Сервисы Google Play> Хранилище и кеш> Очистить кеш.

- Найдите доступные обновления системного программного обеспечения: Настройки> Система> Обновление системы> Проверить наличие обновлений .

- Удалите и повторно добавьте свою учетную запись Google: перейдите в «Настройки »> «Пароли и учетные записи»> «Учетная запись Google»> «Удалить учетную запись ».

Связано: Это лучшие продукты Google, которые вы можете купить

Отключение и прием

Вы на природе? Может быть, вы находитесь в бетонном здании.Или вы просто проезжаете через зону с нестабильным приемом. Всегда есть вероятность, что вы недоступны для сети, что вызовет проблемы с вашими мобильными данными.

Также учтите, что, хотя это бывает редко, сети операторов связи тоже могут выходить из строя, вызывая перебои в обслуживании. Нам нравится рекомендовать DownDetector.com проверять, когда службы не работают. Веб-сайт собирает отчеты потребителей и сообщает вам о сбоях в работе. Также есть живая карта, чтобы увидеть, является ли проблема локальной. Просто войдите туда, введите своего оператора связи и нажмите кнопку поиска.Если сеть не работает, все, что вы можете сделать, это подождать.

Сбросить APN

APN - это то, как ваш телефон подключается к сети вашего оператора мобильной связи. Думайте об этом как о пароле Wi-Fi для мобильных данных, но гораздо более сложном, с настройками IP, данными шлюза и т. Д.

Д.

Как сбросить настройки APN:

- Откройте приложение Settings .

- Войдите в Сеть и Интернет .

- Выберите Мобильная сеть .

- Развернуть Расширенный .

- Hit Имена точек доступа .

- Нажмите на кнопку меню с тремя точками.

- Выберите Сбросить до значений по умолчанию .

Сбросить настройки сети

Эдгар Сервантес / Android Authority

Если ни одна из вышеперечисленных опций не работает, это может означать, что некоторые посторонние настройки были изменены в процессе. Вероятно, это связано с сетью, поэтому сброс настроек сети до заводских значений по умолчанию может решить проблему.

Как сбросить настройки сети:

- Откройте приложение Settings .

- Выберите Система .

- Войдите в Параметры сброса .

- Hit Сбросить Wi-Fi, мобильный телефон и Bluetooth .

- Нажмите Сбросить настройки .

Сброс заводских данных

Если ничего не помогает восстановить мобильные данные, выполните сброс данных до заводских. Это сотрет все на вашем телефоне и вернет все настройки к заводским значениям по умолчанию.Это означает, что ваш телефон останется таким, каким вы его включили в первый раз (программно).

Это устраняет практически все проблемы с программным обеспечением, с которыми вы можете столкнуться. Это лучшее решение многих проблем, но его следует использовать в крайнем случае из-за неудобств, связанных с удалением всех данных.

Как восстановить заводские настройки телефона Android:

- Откройте приложение Settings .

- Выберите Система .

- Войдите в Параметры сброса .

- Hit Стереть все данные (возврат к заводским настройкам) .

- Нажмите Стереть все данные .

Подробнее: Как восстановить заводские настройки устройств Android

Обратиться за профессиональной помощью

Эдгар Сервантес / Android Authority

Теперь, если это не поможет, вам, вероятно, потребуется профессиональная проверка устройства. На данный момент это может быть аппаратная проблема. Обратитесь к производителю телефона, оператору связи или, возможно, даже к Google.Возможно, пришло время обратиться к вашей страховой компании, если она у вас есть.

Next: Лучшие варианты страховки для смартфонов

КомментарииИзвестные проблемы и ограничения

При использовании машинного обучения Cloudera вы можете столкнуться с некоторыми известными проблемами.

Максимальная длина поля имени пользователя составляет 50 байтов (DSE-18016)

В CML длина поля имени пользователя ограничена 50 байтами, что меньше соответствующего

длина поля в Microsoft Active Directory. Это может вызвать ошибки при подключении пользователя, у которого

длинное имя.

Это может вызвать ошибки при подключении пользователя, у которого

длинное имя.

Сбой доступа к озеру данных с поддержкой RAZ (DSE-18290)

Если вы пытаетесь получить доступ к хранилищу в озере данных версии 7.2.11 или выше, и RAZ включен, устаревшие движки не будут работать. Эта проблема не возникает при использовании среды выполнения машинного обучения. с последней версией дополнения Spark.

Не удалось установить рабочее пространство (CDPSDX-3207)

Установка может завершиться ошибкой: Ошибка установки.Время установки истекло. Это периодическая ошибка.

Решение: попробуйте снова установить рабочую область.

Графана (DSE-18499)

Пользователи могут не видеть какие-либо предварительно заполненные информационные панели Grafana (кластер, контейнеры, Node, Models) внутри рабочего пространства машинного обучения.

Происхождение данных не сообщается в Атлас (DSE-16706)

Регистрация происхождения обучающих данных с помощью файла связывания не работает.

Дополнение среды выполнения не загружается (DSE-16200)

Надстройка среды выполнения Spark может дать сбой при обновлении рабочей области.

Решение: Чтобы решить эту проблему, попробуйте перезагрузить надстройку. В в меню параметров рядом с отказавшей надстройкой выберите Перезагрузить.

Истекло время инициализации рабочего пространства CML

При инициализации рабочего пространства CML для процесса может истечь время ожидания с ошибкой, аналогичной Предупреждение FailedMount или Не удалось синхронизировать секретный кеш: время ожидания истекло

жду состояния. Это может произойти в AWS или Azure.

Решение: удалите рабочую область и повторите подготовку.

Подключение конечных точек CML от DataHub и Cloudera Data Engineering (DSE-14882)

Когда службы CDP подключаются к службам CML, если рабочее пространство ML предоставляется в общедоступном

подсети, трафик сначала маршрутизируется из VPC, а затем возвращается обратно. В частном облаке

CML, трафик не маршрутизируется извне.

В частном облаке

CML, трафик не маршрутизируется извне.

Предупреждение браузера Chrome при доступе к рабочей области машинного обучения (DSE-14652)

Некоторые браузеры (Chrome 86 и выше) могут отображать следующее сообщение, когда пользователь пытается для доступа к рабочей области, настроенной без TLS. Информация, которую вы

собирается отправить небезопасно. Обходной путь: примите и обойдите предупреждение браузера.

Explanation: Chrome 86 и выше отображает предупреждения при отправке или перенаправлении форм. на http: //, что имеет место при подключении к рабочей области, настроенной без TLS, с использованием SSO. Рабочее пространство по-прежнему будет функционально во всех отношениях, если вы примете и обойдете браузер. предупреждение. Невозможно включить TLS в рабочей области, созданной без TLS.

Среда с поддержкой Ranger и RAZ (OPSAPS-59476)

При использовании сред с поддержкой Ranger и RAZ в CML общедоступного облака выполните следующие действия. команды на терминале сеанса или встроенные в код пользователя перед выполнением любых других

операции:

команды на терминале сеанса или встроенные в код пользователя перед выполнением любых других

операции: sed -i "s / http: / https: / g"

/etc/hadoop/conf/core-site.xml sed -i "s / http: / https: / g"

/etc/hive/conf/core-site.xml Сиротские блочные тома EBS после удаления рабочего пространства машинного обучения (DSE-14606)

Если рабочее пространство CML на AWS удалено с помощью выпуска от 3 февраля 2021 г. (1.15.0-b72) из

CML Control Plane, бесхозные блочные тома EBS могут быть оставлены позади. Состояние любого сироты

тома отображаются как Доступные в консоли EC2 (вы можете увидеть список

томов, перейдя к). Тома имеют имена, похожие на kubernetes-dynamic-pvc- , помечены kubernetes.io/created-for/pvc/namespace":"mlx ". Эти бесхозные тома EBS

необходимо удалить, чтобы предотвратить утечку облачных ресурсов.

Обновление не поддерживается в NFS v4.х (DSE-14519, DSE-14077)

Обновление рабочих областей машинного обучения в Azure, настроенных с использованием внешних служб NFS с использованием NFS v4.x протокол в настоящее время не поддерживается.

Приложения могут не запускаться после обновления Kubernetes (DSE-14355)

В некоторых случаях приложения, которые работали до обновления Kubernetes, могут не запускаться. после обновления Kubernetes. Пользователи, имеющие доступ к таким приложениям, должны перезапустить их. вручную.

Прозрачный прокси-сервер поддерживается только на AWS (DSE-13937)

Cloudera Machine Learning при использовании в общедоступном облаке AWS поддерживает прозрачные прокси.Прозрачный прокси-сервер позволяет CML проксировать веб-запросы без использования какого-либо конкретного браузера.

настраивать. В нормальном режиме работы CML требует доступа к нескольким внешним доменам. За

для получения дополнительной информации см .: Назначения исходящего сетевого доступа.

За

для получения дополнительной информации см .: Назначения исходящего сетевого доступа.

Невозможно ограничить доступ к приложению (DSE-13928, DSE-6651)

Авторизация, используемая приложениями, может быть устаревшей. Например, если пользователь удален из проекта в CDSW или CML (больше нет доступа для чтения к проекту и его приложения), этот пользователь может продолжать иметь доступ к приложению, если он получил доступ приложение до того, как их доступ был отозван.

Обходной путь: при обновлении разрешений проекта, в котором есть приложения, перезапустите приложения, чтобы гарантировать, что приложения используют актуальную авторизацию.

Время ожидания сеансов Jupyter Notebook не истекает (DSE-13741)

сеансов Jupyter Notebook в устаревшем движке: с 8 по

двигатель: 13 не выходить после IDLE_MAXIMUM_MINUTES из

бездействие. Они будут работать до SESSION_MAXIMUM_MINUTES (что составляет семь

дней по умолчанию).

Временное решение

Вы можете изменить конфигурацию кластера, чтобы применить исправление для этой проблемы. Изменять команда редактора для Jupyter Notebook в каждом движке, который ее использует, на следующее:

NOTEBOOK_TIMEOUT_SECONDS = $ (python3 -c «print ($ {IDLE_MAXIMUM_MINUTES} * 60)«)

/ usr / local / bin / jupyter notebook --no-browser --ip = 127.0.0.1 --port = $ {CDSW_APP_PORT}

--NotebookApp.token = --NotebookApp.allow_remote_access = True --NotebookApp.quit_button = Ложь

--log-level = ОШИБКА --NotebookApp.shutdown_no_activity_timeout = 300

--MappingKernelManager.cull_idle_timeout = $ {NOTEBOOK_TIMEOUT_SECONDS}

--TerminalManager.cull_inactive_timeout = $ {NOTEBOOK_TIMEOUT_SECONDS}

--MappingKernelManager.cull_interval = 60 --TerminalManager.cull_interval = 60

--MappingKernelManager.cull_connected = Истина Это делает следующее:- Убивает все работающие записные книжки после IDLE_MAXIMUM_MINUTES бездействия

- Завершает сеанс CDSW / CML, в котором запущен Jupyter, через 5 минут без ноутбуки

Отсутствует кнопка воспроизведения в сеансах CML со средами выполнения ML (DSE-13629)

Для сеансов ML Runtime кнопка Play может не отображаться.

Временное решение:

Вы все еще можете запустить код сеанса, выбрав Run–> Run All или Выполнить -> Выполнить строки, когда кнопка Воспроизвести не отображается в пользовательском интерфейсе.

Запланированное задание не выполняется после переключения на среду выполнения, приложение не может быть перезапущен (DSE-13573)

ML Runtimes - это новая функция в текущем выпуске. Хотя теперь вы можете изменить свой существующие проекты с Engine на ML Runtime, в настоящее время не рекомендуется переносить существующие проекты.

Приложения и задания, созданные с помощью движков, могут быть затронуты после изменения их проекта. использовать среды выполнения ML на основе следующего:- Вы будете вынуждены перейти на среды выполнения ML, если попытаетесь обновить соответствующий редактор / ядро настройки заданий, моделей, экспериментов или приложений

- Приложения не могут быть перезапущены из пользовательского интерфейса в перенесенном проекте, если только ML Runtime

настройки обновляются для этого приложения.

Проблемы с производительностью NFS на AWS EFS (DSE-12404)

CML использует NFS в качестве файловой системы для хранения данных приложений и пользователей.Производительность NFS может быть намного медленнее, чем ожидалось, в ситуациях, когда специалист по данным пишет очень большое число (обычно тысячи) небольших файлов. Примеры задач включают: использование git clone для клонирования очень большого репозитория исходного кода (например, TensorFlow) или с помощью pip для установки пакета Python, который включает код JavaScript (например, сюжетно). Снижение производительности особенно характерно для CML на AWS. (который использует EFS), но его можно увидеть в других средах.

Отключить загрузку и скачивание файлов (DSE-12065)

Вы не можете отключить загрузку и загрузку файлов при использовании Jupyter Notebook.

Сбой операции удаления рабочего пространства (DSE-8834)

Операция удаления рабочего пространства завершается ошибкой, если создание рабочего пространства все еще продолжается.

CML не поддерживает изменение ограничений масштабирования ЦП / графического процессора для подготовленных рабочих пространств машинного обучения. (DSE-8407)

При инициализации рабочего пространства CML в настоящее время поддерживает максимум 30 узлов каждого типа: Процессоры и графические процессоры.В настоящее время CML не позволяет увеличить этот предел для существующих рабочие места.

Временное решение:- Войдите в веб-интерфейс CDP по адресу https://console.us-west-1.cdp.cloudera.com, используя свои корпоративные учетные данные или любые другие учетные данные, полученные от администратора CDP.

- Щелкните "Рабочие области машинного обучения".

- Выберите рабочее пространство, пределы которого вы хотите изменить, и перейдите в его Страница с подробностями.

- Скопируйте идентификатор Liftie Cluster ID рабочего пространства.

Он должен быть формата,

Он должен быть формата, лифти- abcdefgh. - Войдите в консоль AWS EC2 и нажмите Auto Scaling. Группы.

- Вставьте идентификатор кластера Liftie в поле поискового фильтра и нажмите клавишу ВВОД.

- Щелкните группу автоматического масштабирования с таким именем, как:

liftie-abcdefgh-ml-pqrstuv-xyz- cpu-worker -0-NodeGroup.Особенно обратите внимание на «cpu-worker» в середине строки. - На странице «Подробности» этой группы автоматического масштабирования нажмите «Изменить».

- Установите желаемое значение Max capacity и нажмите Save .

Обратите внимание, что CML не поддерживает уменьшение максимального количества экземпляров группы автоматического масштабирования из-за

с определенными ограничениями в AWS.

SSO не работает, если первый пользователь, получивший доступ к рабочей области машинного обучения, не является сайтом Администратор

Проблема: Если пользователь, которому назначена роль MLUser, является первым пользователем, веб-приложение отобразит ошибку.

Обходной путь: Любой пользователь, которому назначена роль MLAdmin, всегда должен быть первым пользователем, получить доступ к рабочему пространству машинного обучения.

API не предписывает максимальное количество узлов для рабочих пространств машинного обучения

Проблема: Когда API используется для предоставления новых рабочих пространств машинного обучения, он не обеспечивает принудительное верхний предел диапазона автомасштабирования.

Узлы рабочего пространства машинного обучения с уменьшением масштаба не работают должным образом (MLX-637, MLX-638)

Проблема: Узлы масштабирования не работают так плавно, как ожидалось, из-за отсутствия

Bin Packing в планировщике Spark по умолчанию, а также потому, что динамическое размещение в настоящее время не выполняется. включено.В результате в настоящее время модули инфраструктуры, модули драйвера / исполнителя Spark и сеанс

стручки помечаются как не подлежащие выселению с помощью

включено.В результате в настоящее время модули инфраструктуры, модули драйвера / исполнителя Spark и сеанс

стручки помечаются как не подлежащие выселению с помощью cluster-autoscaler.kubernetes.io/safe-to-evict: "ложная" аннотация .

Типы измерений

Типы измерений

Эта страница относится к параметру

типа, который является частью меры.

Типтакже может использоваться как часть измерения или фильтра, описанного на странице документации по типам измерений, фильтров и параметров.Тип

также может использоваться как часть группы измерений, описанной на странице документации параметрагруппа_измерений.

view: view_name {

measure: field_name {

type: measure_field_type

}

}

Эта страница содержит подробную информацию о различных типах, которые могут быть присвоены мере. У меры может быть только один тип, и по умолчанию используется значение

У меры может быть только один тип, и по умолчанию используется значение , строка , если тип не указан.

Некоторые типы мер имеют вспомогательные параметры, которые описаны в соответствующем разделе.

Каждый тип меры попадает в одну из следующих категорий. Эти категории определяют, выполняет ли тип меры агрегирование, тип полей, на которые может ссылаться этот тип меры, и можно ли отфильтровать тип меры с помощью параметра Filters :

- Агрегатные меры : Типы агрегированных мер выполняют агрегирование, например,

суммаисреднее. Агрегированные меры могут ссылаться только на измерения, но не на другие меры.Это единственный тип меры, который работает с параметромFilters. - Неагрегированные меры : Неагрегированные меры, как следует из названия, представляют собой типы мер, которые не выполняют агрегирование, например

номерида нет. Эти типы мер выполняют простые преобразования и, поскольку они не выполняют агрегирования, могут ссылаться только на агрегированные меры или ранее агрегированные измерения. Вы не можете использовать параметр

Эти типы мер выполняют простые преобразования и, поскольку они не выполняют агрегирования, могут ссылаться только на агрегированные меры или ранее агрегированные измерения. Вы не можете использовать параметр Filtersс этими типами мер. - Меры Post-SQL : Меры Post-SQL - это особые типы мер, которые выполняют определенные вычисления после того, как Looker сгенерировал запрос SQL. Они могут ссылаться только на числовые меры или числовые измерения. Вы не можете использовать параметр

Filtersс этими типами мер.

| Тип | Категория | Описание |

|---|---|---|

среднее | Совокупный | Создает среднее (среднее) значений в столбце |

average_distinct | Совокупный | Правильно генерирует среднее (среднее) значений при использовании денормализованных данных. Полное описание см. В приведенном ниже определении. В приведенном ниже определении. |

счетчик | Совокупный | Создает количество строк |

count_distinct | Совокупный | Создает количество уникальных значений в столбце |

дата | Неагрегатное | Для мер, содержащих даты |

список | Совокупный | Создает список уникальных значений в столбце |

макс | Совокупный | Создает максимальное значение в столбце |

медиана | Совокупный | Создает медианное значение (среднее значение) значений в столбце |

median_distinct | Совокупный | Правильно генерирует медианное значение (среднее значение) значений, когда соединение вызывает разветвление. Полное описание см. В приведенном ниже определении. Полное описание см. В приведенном ниже определении. |

мин | Совокупный | Создает минимальное значение в столбце |

номер | Неагрегатное | Для мер, содержащих числа |

процентов от предыдущего | Post-SQL | Создает процентную разницу между отображаемыми строками |

процентов от общей суммы | Post-SQL | Создает процент от общего количества для каждой отображаемой строки |

процентиль | Совокупный | Создает значение в указанном процентиле в столбце |

percentile_distinct | Совокупный | Правильно генерирует значение в указанном процентиле, когда соединение вызывает разветвление. Полное описание см. В приведенном ниже определении. |

рабочий_общий | Post-SQL | Создает промежуточную сумму для каждой отображаемой строки |

строка | Неагрегатное | Для показателей, содержащих буквы или специальные символы (как в MySQL GROUP_CONCAT функция) |

сумма | Совокупный | Создает сумму значений в столбце |

sum_distinct | Совокупный | Правильно генерирует сумму значений при использовании денормализованных данных. Полное описание см. В приведенном ниже определении. |

да нет | Неагрегатное | Для полей, которые покажут, правда ли что-то или нет. |

внутр | Неагрегатное | УДАЛЕНО 5.4 Заменено на тип: номер |

тип: среднее усредняет значения в заданном поле. Это похоже на функцию SQL

Это похоже на функцию SQL AVG .Однако, в отличие от написания необработанного SQL, Looker будет правильно вычислять средние значения, даже если соединения вашего запроса содержат разветвления.

Параметр sql для типа : среднее значение мер может принимать любое допустимое выражение SQL, которое приводит к столбцу числовой таблицы, измерению LookML или комбинации измерений LookML.

тип: среднее значение полей можно отформатировать с помощью параметров value_format или value_format_name .

Например, следующий LookML создает поле с именем avg_order путем усреднения измерения sales_price , а затем отображает его в денежном формате ($ 1,234.56):

measure: avg_order { тип: средний sql: $ {sales_price} ;; value_format_name: usd }

type: average_distinct предназначен для использования с денормализованными наборами данных. Он усредняет неповторяющиеся значения в данном поле на основе уникальных значений, определенных параметром

Он усредняет неповторяющиеся значения в данном поле на основе уникальных значений, определенных параметром sql_distinct_key .

Это продвинутая концепция, которую можно более четко пояснить на примере. Рассмотрим денормализованную таблицу, подобную этой:

| Код позиции для заказа | Номер заказа | Заказать Доставка |

|---|---|---|

| 1 | 1 | 10.00 |

| 2 | 1 | 10,00 |

| 3 | 2 | 20,00 |

| 4 | 2 | 20,00 |

| 5 | 2 | 20,00 |

В этой ситуации вы можете видеть, что для каждого заказа есть несколько строк. Следовательно, если вы добавите простой показатель типа

Следовательно, если вы добавите простой показатель типа : среднее значение для столбца order_shipping , вы получите значение 16.00, хотя фактическое среднее значение составляет 15,00.

# НЕ будет вычислять правильное среднее значение measure: avg_shipping { тип: средний sql: $ {order_shipping} ;; }

Чтобы получить точный результат, вы можете объяснить Looker, как он должен идентифицировать каждый уникальный объект (в данном случае каждый уникальный порядок), используя параметр sql_distinct_key . Этот будет вычислить правильную сумму 15,00:

# Подсчитает правильное среднее measure: avg_shipping { тип: average_distinct sql_distinct_key: $ {order_id} ;; sql: $ {order_shipping} ;; }

Обратите внимание, что каждое уникальное значение sql_distinct_key должно иметь только одно соответствующее значение в sql .Другими словами, приведенный выше пример работает, потому что каждая строка с order_id из 1 имеет тот же order_shipping из 10,00, каждая строка с order_id из 2 имеет тот же order_shipping из 20,00, и скоро.

type: average_distinct Поля можно отформатировать с помощью параметров value_format или value_format_name .

type: count выполняет подсчет таблицы, аналогично функции SQL COUNT .Однако, в отличие от написания необработанного SQL, Looker будет правильно вычислять счетчики, даже если соединения вашего запроса содержат разветвления.

type: count не поддерживают параметр sql , поскольку мера типа type: count выполняет подсчет таблиц на основе первичного ключа таблицы. Если вы хотите выполнить подсчет таблицы для поля, отличного от первичного ключа таблицы, используйте показатель типа : count_distinct .

Например, следующий LookML создает поле number_of_products :

view: products { measure: number_of_products { тип: количество Drill_fields: [product_details *] # необязательно } }

Очень часто при определении меры типа : count предоставляют параметр Drill_fields (для полей), чтобы пользователи могли видеть отдельные записи, составляющие счетчик, при нажатии на нее.

Когда вы используете меру типа

: счетчикв Исследовании, визуализация помечает полученные значения именем представления, а не словом «Счетчик». Чтобы избежать путаницы, мы рекомендуем использовать множественное число для имени вашего представления, выбрав Показать полное имя поля в разделе Series в настройках визуализации или использоватьview_labelс версией во множественном числе имени вашего представления.

Если вы хотите выполнить COUNT (а не COUNT_DISTINCT ) для поля, которое не является первичным ключом, вы можете сделать это, используя показатель типа : число .Дополнительные сведения см. В статье Справочного центра «Разница между типами показателей count и count_distinct ».

Вы можете добавить фильтр к показателю типа : подсчитать , используя параметр Filters .

type: count_distinct вычисляет количество различных значений в заданном поле. Он использует функцию SQL COUNT DISTINCT .

Параметр sql для type: count_distinct Показатели могут принимать любое допустимое выражение SQL, которое приводит к столбцу таблицы, измерению LookML или комбинации измерений LookML.

Например, следующий LookML создает поле number_of_unique_customers , которое подсчитывает количество уникальных идентификаторов клиентов:

measure: number_of_unique_customers { тип: count_distinct sql: $ {customer_id} ;; }

Вы можете добавить фильтр к показателю типа : count_distinct , используя параметр Filters .

тип: дата используется с полями, содержащими даты.

Параметр sql для мер type: date может принимать любое допустимое выражение SQL, которое приводит к дате. На практике этот тип используется редко, поскольку большинство агрегатных функций SQL не возвращают даты. Одним из распространенных исключений является

На практике этот тип используется редко, поскольку большинство агрегатных функций SQL не возвращают даты. Одним из распространенных исключений является MIN или MAX измерения даты.

Например, следующий LookML создает поле most_recent_order_date , взяв максимальное значение из поля order_date :

measure: most_recent_order_date { тип: дата sql: MAX ($ {order_date}) ;; convert_tz: нет }

В этом примере type: date можно опустить, и значение будет рассматриваться как строка, потому что string является значением по умолчанию для типа .Однако вы получите лучшую возможность фильтрации для пользователей, если вы используете тип : дата . Параметр convert_tz предотвращает двойное преобразование часового пояса. Эта концепция более подробно описана в этой статье Справочного центра.

Вы можете использовать параметр datatype с type: date , чтобы повысить производительность запроса, указав тип данных даты, которые использует ваша таблица базы данных.

type: list создает список различных значений в данном поле.Это похоже на функцию MySQL GROUP_CONCAT .